Rapport de recherche sur l'état de la recherche sur site dans l'enseignement supérieur avec The Chronicle of Higher Education | Télécharger le rapport

Rapport de recherche sur l'état de la recherche sur site dans l'enseignement supérieur avec The Chronicle of Higher Education | Télécharger le rapport

RechercheStax Solution de recherche de site

Caractéristiques

Tarification

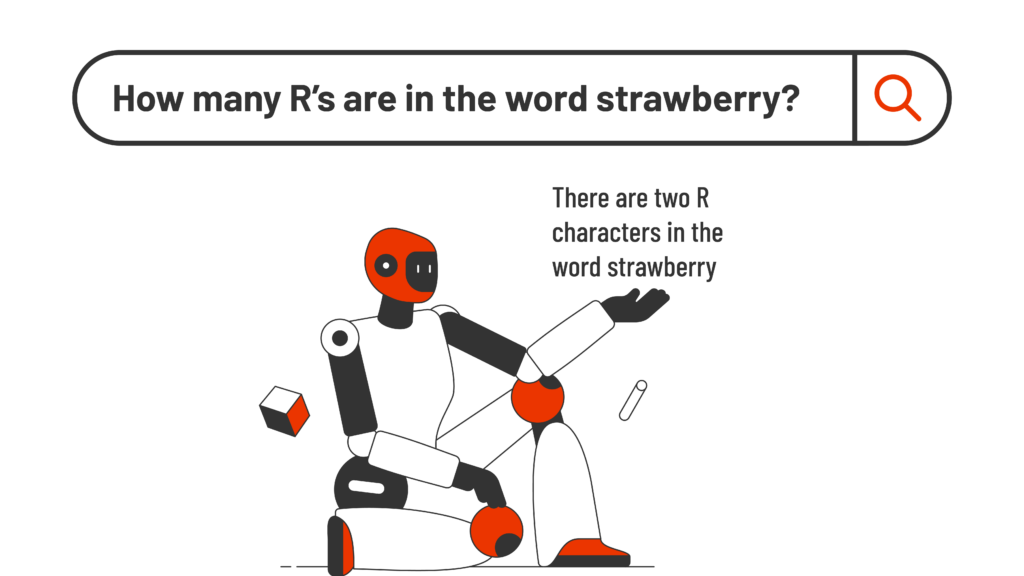

La solution SearchStax Site Search offre aux spécialistes du marketing l'agilité dont ils ont besoin pour optimiser les résultats du site Web.

Présentation du produitRechercheStax Service de recherche géré

SearchStax Managed Search décharge la gestion de Solr, offrant aux équipes informatiques une agilité opérationnelle accrue.

Présentation du produit- Tarifs SearchStaxDes tarifs et des plans qui évoluent avec vous

Solution de recherche de site Solution de recherche de site Web avancée

Service de recherche géréInfrastructure Solr hautement disponible et évolutive

- Ressources SearchStaxVotre plateforme d'informations sur la recherche, fournie par les experts de SearchStax

centre d'apprentissage

ressources produit

ÉVÉNEMENTS